GPT‑5.3‑Codex‑Spark

GPT-5.3-Codex-Spark : Le nouveau modèle OpenAI ultra-rapide pour le codage en temps réel via Cerebras.

Découvrez GPT-5.3-Codex-Spark, une version optimisée de GPT-5.3-Codex conçue pour la programmation interactive instantanée. Grâce au matériel de Cerebras, ce modèle atteint une vitesse de 1000 tokens par seconde, révolutionnant l'expérience de développement logiciel.

2026-02-15

210067.3K

GPT‑5.3‑Codex‑Spark Informations sur le produit

GPT-5.3-Codex-Spark : L'Ère du Codage en Temps Réel avec OpenAI

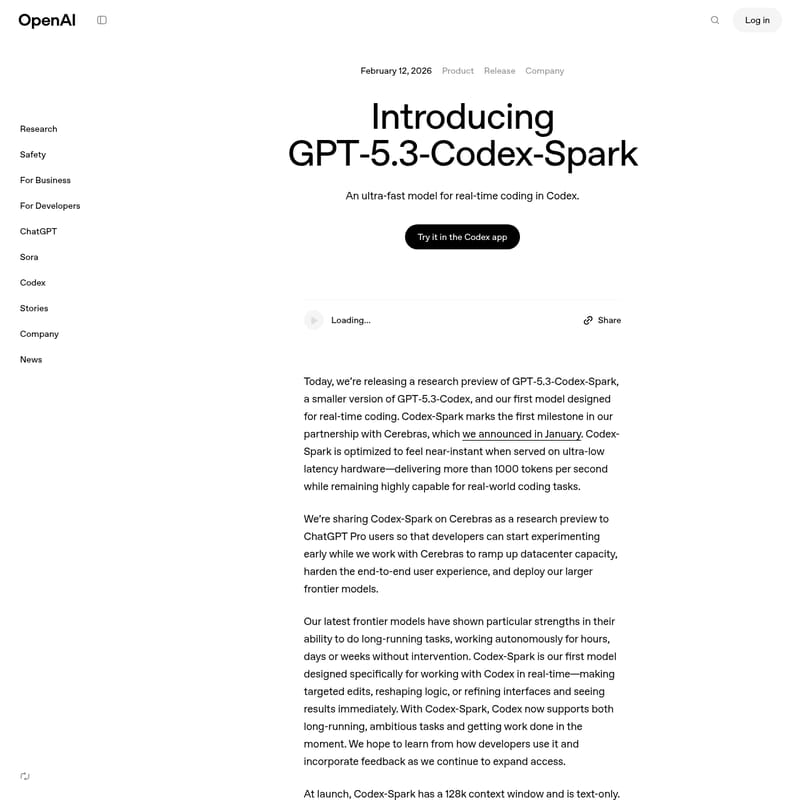

Le 12 février 2026, OpenAI a marqué une étape historique dans le développement logiciel avec le lancement de GPT-5.3-Codex-Spark. Ce nouveau modèle, plus compact que son prédécesseur le GPT-5.3-Codex, est spécifiquement conçu pour offrir une expérience de codage ultra-rapide et interactive. Fruit d'un partenariat stratégique avec Cerebras, ce modèle redéfinit la réactivité dans l'écosystème Codex.

Qu'est-ce que GPT-5.3-Codex-Spark ?

GPT-5.3-Codex-Spark est une version optimisée de la famille GPT-5.3-Codex, dédiée au codage en temps réel. Contrairement aux modèles frontaliers qui se concentrent sur des tâches de longue haleine, le Codex-Spark est taillé pour l'immédiateté. Il permet aux développeurs d'effectuer des modifications ciblées, de remodeler la logique ou d'affiner des interfaces avec un ressenti quasi instantané.

Servi sur le matériel de pointe de Cerebras, le GPT-5.3-Codex-Spark est capable de délivrer plus de 1000 tokens par seconde. Cette performance exceptionnelle garantit une latence ultra-faible, transformant l'outil en un véritable collaborateur en direct.

Caractéristiques de GPT-5.3-Codex-Spark

Le modèle GPT-5.3-Codex-Spark se distingue par plusieurs innovations techniques et capacités de performance :

- Vitesse Révolutionnaire : Grâce au Wafer Scale Engine 3 de Cerebras, le modèle offre une vitesse d'inférence sans précédent.

- Fenêtre de Contexte de 128k : Malgré sa taille réduite, il gère d'importants volumes de texte pour comprendre le contexte global du projet.

- Optimisation de la Latence de Bout en Bout : OpenAI a réduit le délai du premier token de 50 % et l'overhead par aller-retour client/serveur de 80 % via des connexions WebSocket persistantes.

- Performance Agentique : Sur les benchmarks SWE-Bench Pro et Terminal-Bench 2.0, il surpasse les attentes en accomplissant des tâches d'ingénierie logicielle en une fraction du temps requis par le GPT-5.3-Codex standard.

- Sécurité Intégrée : Il inclut les mêmes protocoles de sécurité et d'entraîneinent cyber-pertinent que les modèles principaux de la gamme GPT-5.

Cas d'Utilisation (Use Case)

Le GPT-5.3-Codex-Spark excelle dans les flux de travail où l'agilité est primordiale. Voici comment les développeurs peuvent l'exploiter :

- Collaboration Interactive : Interrompez et redirigez le modèle pendant qu'il génère du code pour un réglage fin immédiat.

- Modifications Ciblées : Utilisez le Codex-Spark pour des retouches rapides de logique sans avoir besoin d'exécuter des tests automatiques lourds (sauf demande expresse).

- Prototypage Rapide : Construisez des applications simples, comme un jeu de Snake, ou planifiez la structure d'un projet en quelques secondes.

- Développement Multimodal Futur : Bien qu'actuellement limité au texte, il prépare le terrain pour des interactions plus complexes intégrant l'image et le son.

Disponibilité et Intégration

Le modèle est désormais disponible en tant qu'aperçu de recherche (research preview) pour les utilisateurs de ChatGPT Pro. L'accès se fait via :

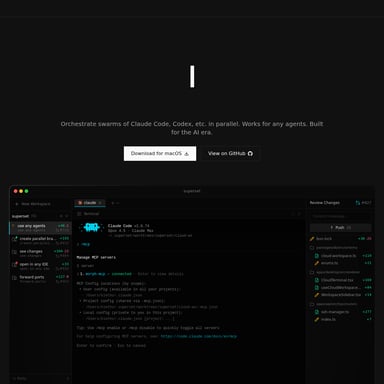

- L'application Codex dédiée.

- L'interface en ligne de commande (CLI).

- L'extension pour VS Code.

« Ce qui nous enthousiasme le plus avec le GPT-5.3-Codex-Spark, c'est de découvrir ce qu'une inférence rapide rend possible — de nouveaux modèles d'interaction et une expérience de modèle fondamentalement différente. » — Sean Lie, CTO de Cerebras.

FAQ

Qui peut accéder à GPT-5.3-Codex-Spark ?

Il est actuellement accessible aux abonnés ChatGPT Pro via l'application Codex, le CLI et l'extension VS Code. Un petit groupe de partenaires API y a également accès.

Quelle est la vitesse de ce modèle ?

Grâce au partenariat avec Cerebras, GPT-5.3-Codex-Spark peut dépasser les 1000 tokens par seconde, offrant une expérience fluide et sans interruption.

Le modèle supporte-t-il les images ?

Pour le moment, le modèle est uniquement textuel, mais OpenAI prévoit d'introduire des capacités multimodales dans les futures versions de cette famille.

Y a-t-il des limites d'utilisation ?

Oui, durant la phase d'aperçu de recherche, le Codex-Spark possède ses propres limites de débit (rate limits) indépendantes des limites standard, qui peuvent être ajustées selon la demande.